あのLIVE AIDの興奮を再び!完全オンラインの音楽フェス「MUSER Fest」を支えた、Unreal Engineのあたらしい活用法

sync.devでは、2021年に開催されたオンライン音楽フェス「MUSER Fest.2021 ‒MUSIC AID-」で舞台演出装置の開発を担当いたしました。本記事では、主催の株式会社BEAMING代表・次呂久さんと、テクニカルディレクションを担当したsync.dev代表・岡田との対談インタビューをお届けします。

フェスの再現を超えた、XRらしい演出を。アイディア実現に必要だったのは、スピード感とR&Dの成果

――はじめに「MUSER」というサービスや「MUSER Fest.2021 ‒MUSIC AID-(以下、MUSER Fest)」の概要について教えてください。

BEAMING 次呂久さん(以下、次呂久さん)

「MUSER」は音楽ライブに特化した配信プラットフォームです。当初はインディーズを中心に音源を発掘したり、新しいアーティストとの出会いを楽しめる場所としてスタートしました。そこからライブ市場へと軸足を移し、現在はライブを配信したり、観客も投げ銭によってVJのようにライブ演出を楽しんだりできるサービスを提供しています。

特徴的なのは、自分たちでライブ制作もしている点。ライブ制作をする以上、いつかフェスをやってみたいという思いがあり、完全オンラインの音楽フェス「MUSER Fest」の企画を立ち上げました。

※MUSER Festのキービジュアル

――MUSER Festの企画は、いつ頃から動き始めたのでしょうか?

次呂久さん

具体的に動き始めたのは2021年の1月頃です。アーティストのブッキングは順調で、企画書だけの状態でも「おもしろそうだね」とみんな乗ってきてくれました。

でも僕の頭の中にあったアイディアを実現させるためには、想定していたものでは上手く機能しないことがわかったり、問題が多々出てきてしまったんです。リサーチしたり話を聞いているうちに時間も経ってしまい、「一体誰なら実現できるんだ?」ととても苦慮しました。

一番の課題となっていたのは「照明」です。ステージでは光を多用するので、グリーンバックの切り抜きがうまくいかなかったり、それをリアルタイムで合成するのがかなり難しいという点がずっと解決できずにいたんです。グリーンバックを諦めて、LEDウォールに切り替えることも考えましたが、予算がまったく合わなくて…。コストだけでなく、背景のある範囲でしか演出ができないという制約もあり、やはりグリーンバックで何とかするしかないと腹をくくりました。

そのときに知ったのがZero Density社のReality Engine(Unreal EngineをベースにしたハイエンドリアルタイムCGレンダリングソフト)で、持っているチームを探す中でsync.devに辿り着きました。自分たちがやりたいことを最大化してくれそうな領域の広さに可能性を感じて依頼したのですが、このときもう開催まで2ヶ月を切っていました(苦笑)。

※Zero Density社公式サイトより(https://www.zerodensity.tv/ja/)

ーー話を頂いて、岡田さんはどのように動いていったのでしょうか?

sync.dev 岡田(以下、岡田)

最初の打ち合わせの前に情報を頂き、MUSERさんのサービスや普段やっていることを理解した上で、MUSERチームにとってどのようなものが良いかを構想し始めました。単純にグリーンバックでやりたいわけではないだろうと思っていましたが、実際に打ち合わせで「VJを入れたい」「ライブだからこそできることをやりたい」といった要望を頂きましたよね。

ーー特にこだわったのはどの部分だったのでしょうか?

次呂久さん

「リアルなフェスの空気感を再現すること」、そして「ただの再現ではない、XRらしさを感じる演出」です。現実ではありえないカメラの動きや、特殊効果に代わるXRならでは演出について、かなり議論しましたが、限られた時間の中で「これなら間に合う」「これは間に合わない」をその場ですぐ判断していただけて本当に助かりました。その段階からリサーチし始めていては、きっと間に合わなかったなと。

岡田

ありがとうございます。そこはこれまでの経験ももちろんながら、既に我々が独自にR&D(Research&Development)で試していたことが活きた部分でもあります。やりたいことを実現するためにR&Dの成果を使わせていただけるのは、我々としても非常にありがたかったですね。

ーー今回の企画にハマる内容のR&Dを既に行っていたのは、偶然でしょうか?それとも、何か意図的なものがあったのでしょうか?

岡田

純粋に我々の興味の方向性がマッチしていたことももちろんありますが、技術的なトレンドも関係しています。このプロジェクトを行っていた頃は、ちょうど照明制御の技術化・ネットワーク化が大きく進んだ時期だったんです。

それまでにも照明をプログラムから制御することはできましたが、Unreal Engineなどのゲームエンジンが照明も含めた舞台演出全般を飲み込みにいく流れが起きています。sync.devでは以前から音楽ライブやイベントをやっていたため、舞台制御に関することはこの案件の前からR&Dを始めていました。それがぴたりとはまった形ですね。

※MUSER Festの会場イメージ

照明さんがUnreal Engineを使いこなすには? クリエイターの可能性を広げる“オリジナル卓”の制作

ーー先ほどこだわりの話で「フェスの空気感を、XRならではの形で再現する」というお話がありました。具体的なコンセプトや制作のフローを教えてください。

次呂久さん

今回モチーフにしたのは、1985年に行われた「LIVE AID」。あのフェスをイメージしたステージをつくり、当時の感覚を呼び戻したいという思いがありました。LIVE AIDは世界初の中継フェスで、僕らがやろうとしていた「世界中から観れるオンラインフェス」と全く同じことを既に行っていた、言わば「オンラインフェスの先輩」です。それに併せて、配信も実際のLIVE AIDと同じく2ステージ体制で行いました。

岡田

制作のフローとしては、次呂久さん側のアートディレクションの方にデザインとモデルをつくっていただき、私の方でリアルタイムに動くように仕上げていきました。

※MUSER Festの舞台イメージ

併せて観客のCGの制作も行いました。LIVE AIDというと、『ボヘミアン・ラプソディ』(LIVE AID出演シーンがハイライトとなっている、QUEENフレディ・マーキュリーの伝記映画)の公開直後だったこともあり、あのステージ上のフレディから見た一面に広がる観客の絵をみんなイメージしてしまいます(笑)。最初に頂いた希望は数万人でしたが、さすがにそれは無理なので、じゃあどうしようかといろいろとディスカッションしましたね。

ーー今回のプロジェクトで特徴的だったことはなんでしょうか?

岡田

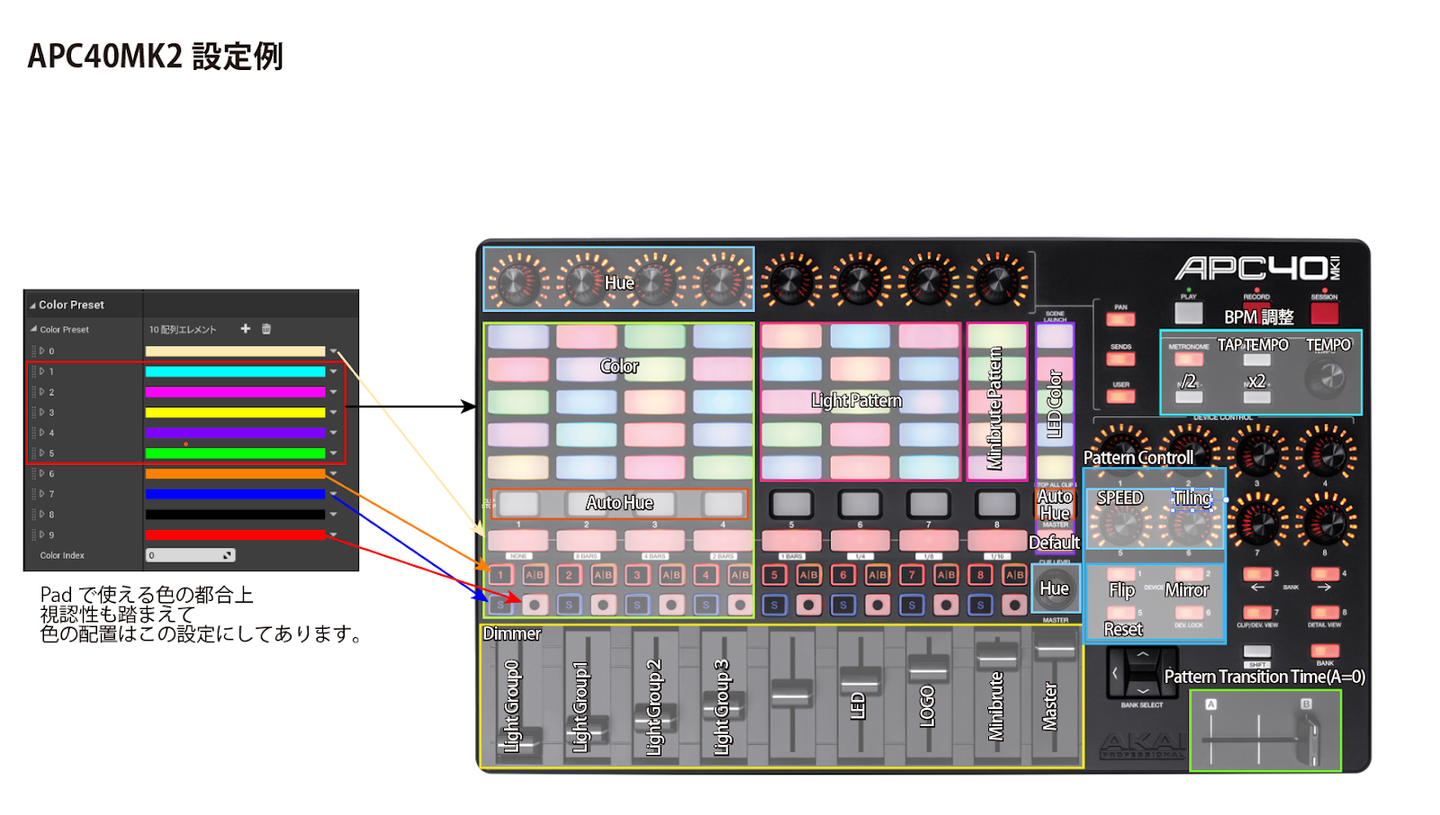

「照明さんに仕事をしてもらおう!」と、照明の制御装置をオリジナルでつくったことでしょうか。

いわゆるXRライブだと、照明演出も音響演出も事前に仕込んでいることがほとんどです。でもライブだから何が起きるかわからないし、そもそも普段ライブ制作をしているチームなので照明さんがいるわけです。それなら、彼らにUnreal Engineを触ってもらおう!というのがこの装置の目的。

でも、さすがに通常のインターフェースで操作してもらうのは難しいので、Unreal Engineでオリジナルの照明卓をつくることにしたんです。

※オリジナルで制作した照明卓のイメージ

岡田

こういったインターフェースを用意することで、初めて触るUnreal Engineを「自分のツール」として照明さんに使ってもらえるようにしました。レクチャーも1回ぐらいしかできないので、その中で理解できるようにと考えてつくってあります。照明さんが普段やっている作業より少し大変かもしれませんが、これがあればすべての会場照明をコントロールできるんです。

次呂久さん

「今現在、世界のどこかでリアルタイムで行われているライブを覗き見るような感覚」を、みなさんに楽しんでほしかったんです。リアルタイムで照明をつくっていくために考えた結果、この解決策が出てきました。

ただし、照明さんが操作するほうがいいのか、VJさんの方がいいのかはかなり議論しましたよね。

岡田

最後まで悩んだ結果、「紙吹雪やパーティクルのようなものはVJさん」「パーライトの制御などは照明さん」と、機能によって卓をつくり分けることにしました。さらに、観客のCGも実はVJさんにコントロールしてもらっています。盛り上がりを制御するのはVJさんの仕事ですから、観客の動きすらもVJワークの一部なのではないかなと。結果的には、照明さんとVJさん、そしてReality Engineのオペレーターの方で、2ステージ分のチームを組みました。

初めてのことばかりだったかと思いますが、いざ始まったら、みんな面白くなっちゃったみたいで(笑)。本番中にも練習を重ね、どんどん操作が上手くなっていましたね。

※ライブ配信中の舞台裏の様子

ーー事前の準備もかなり緻密に行ったと思いますが、現場はいかがでしたか?

岡田

現場にシステムを持っていけるのはせいぜい前日。当然、現場で違うと気づくこともあります。そのため、現場でシステムを直していくことも、片方のステージでやった結果をもう片方に適用するということもたくさんありました。

次呂久さん

床の合成のクオリティがどんどん上がっていったのが印象に残っています。

岡田

そうでしたね!こういうライブもので硬めのイベントだと、より良くなる部分が見つかっても現場では直さないのが一般的です。でも次呂久さんは「これ変えちゃっていいですか?」と聞いたら、「変えていいよ」と言ってくれるので、現場でどんどん良くしていくことができました。

次呂久さん

本当に時間がない中でやっと開催に漕ぎつけたイベントなので、ギリギリまでクオリティを上げていきたいと思っていました。大変ではありましたが、楽しい現場でしたね!

ーー登壇されるアーティストさんには、グリーンバックでのパフォーマンスが初めての方もいたかと思います。皆さんの反応はいかがでしたか?

次呂久さん

グリーンバック撮影の経験がある方はいましたが、今回のような形はやはりみなさん初めてだったようです。事前の資料からなんとなく想像はしつつも、「ステージに立って、ちゃんとテンションあがるのかな…?」とドキドキしていたとお聞きしました。

でもありがたいことに、アーティストのみなさんにもかなり楽しんで頂けました!モニターで自分が配信上でどう見えているのか確認できるようにしたのと、観客の歓声BGMが会場にも流れるようにしていたので、映像を通して観客の存在を感じてもらえたようです。出演する側にもリアルなフェス体験をしてもらいたかったので、この反応は本当に嬉しかったですね。

リアルタイムコンテンツのこれから 「同時性」の本質とは

ーー盛況を受け、今後第2弾なども構想されているのではないかと思います。そのときにどのようなものにしていきたいか、またその実現をテクノロジーにどのようにサポートしてほしいか、教えてください。

次呂久さん

2021年はオンラインのみでしたが、やはりリアルとオンライン両方で開催するフェスをやりたいです。尚且つ、両方あることの意味を、演出ではもちろん、体験としてどうつくれるかにも挑戦したいと思っています。両者をいい塩梅で融合して、どこに接着点があるのか探っていきたいですね。

岡田

その場合、グリーンバックには「生で見たらグリーンバックにしか見えない」という課題があるため、2つの方向性が考えられますね。ひとつは有観客のときはグリーンバックではない手法をとること、 もうひとつは有観客でグリーンバックが有るとはどういうことなのかを突き詰めることです。

前者では、LEDに変える方法がわかりやすいでしょう。LEDにすると、カメラ越しに見てもリッチな画になるし、観客から見てもそこまで不自然ではありません。でも、本来的にはカメラ位置から見た視点でレンダリングしているものなので、観客は“歪んだ画”を見ていることになります。それでいいのかもう一歩踏み込んで考えたいし、まだまだ研究の余地があります。

次呂久さん

あとは空間上での観客の表現ですね。フェス並みの人数の同時接続って、まだ技術的に難しいんでしたっけ?

岡田

現状では、1,000人規模が同時接続する空間を自前でつくることは現実的ではありません。また、接続よりも空間表現の上での制約のほうが大きいかもしれません。『フォートナイト』も100人ぐらいまでで、画面内に映っていない人のことは無視していますから。

方法として、NPC(Non Player Character/ゲームなどの上でプレイヤーが操作しないキャラクターのこと)をたくさん入れて雰囲気を出すことはできますが、次呂久さんがやりたいのはきっとそういうことではないはず。

そしてもっとも重要なのは、「1,000人が同時接続したとき、1,000人のアバターが同じ空間に入るべきか」という点です。次の挑戦ではテクノロジーと折り合いをつけることはもちろん、よりアート的な発想として、「同じ場所を共有することによるライブ体験とは何なのか」を探ることになるのかもしれません。

そろそろ「みんなで一緒に見ている」ことを表現する方法が、「同じ空間にいること」であるべきなのか、一回考えてもいいのかなと思います。「同時に見ている」とは一体どういうことなのか。「たくさんの人と一緒に見ている」という感覚は、一体何によって引き起こされるのか。ニコニコ動画のように、必ずしも同時ではなくとも、同時性はつくれるのではないかと思います。そういった同時性の本質を追及していく中で、次の挑戦が見えてくるのでしょう。

※インタビュー中のお2人。左:BEAMING代表・次呂久さん、右:sync.dev代表・岡田

TEXT&EDIT by Shiho Nagashima

/assets/images/10217850/original/a3b629e9-3bdb-4634-9602-b5466bdd7c54?1661752946)

/assets/images/10217850/original/a3b629e9-3bdb-4634-9602-b5466bdd7c54?1661752946)