こんにちは、 2020年度のサマーインターン生の高橋と申します。

一ヶ月強CTOの徳永さんのもとで、調査および研究に取り組みました。

取り組んだ内容

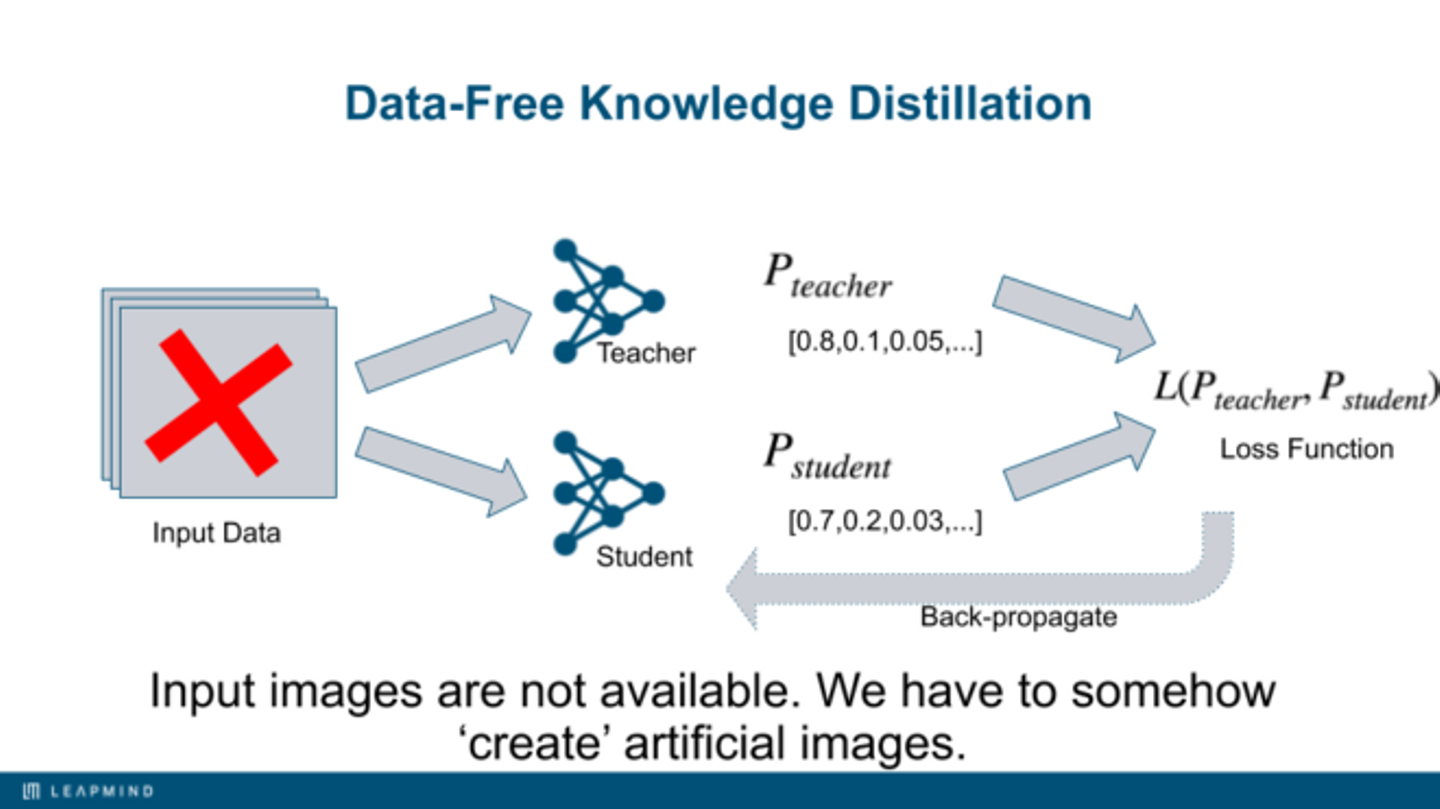

Data-Free Knowledge Distillationと呼ばれる分野に関する調査研究を行いました。ひとことで言えば、学習データを使用せずに学習済みのモデル(teacher network)のみから新たなモデル(student network)へ転移学習(transfer learning)しよう、という枠組みになります。

例えば、データセットを作成する企業と最終的に最適化されたモデルを作成する企業は別の会社かもしれません。もし学習データを必要としなければ、開発の自由度が上がります。

今回のインターンでは、敵対的学習(adversarial learning)による手法を検証しました。この手法では画像を生成する生成器(generator)を導入し、student networkはteacher networkの出力と一致させるように学習し、一方でgeneratorはteacherとstudentの出力が異なるような画像を生成させるよう学習します。

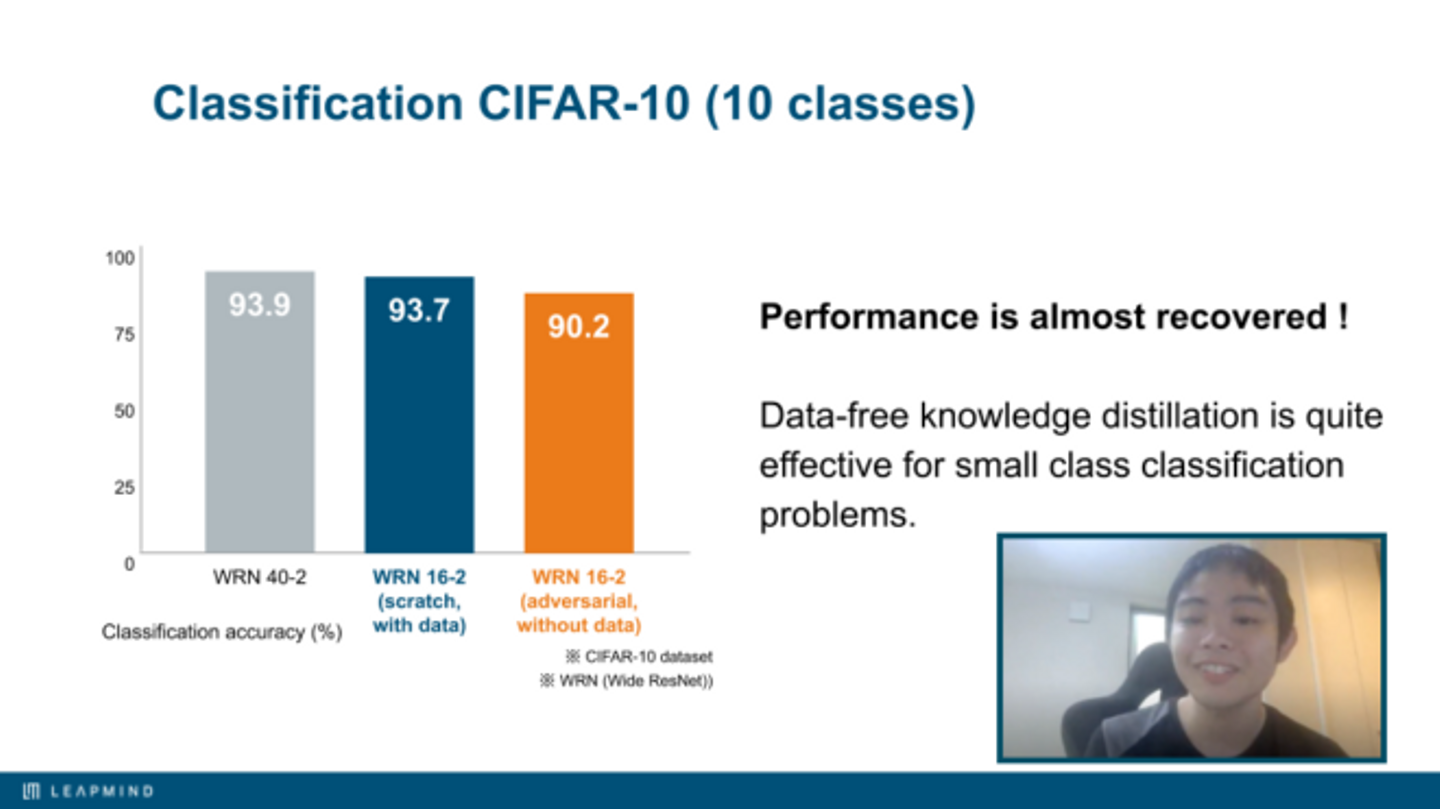

CIFAR-10のようなクラス数が少ない画像分類(image classification)と画像セグメンテーション(semantic segmentation)では、teacher networkとほぼ同程度の性能が実現できることが分かりました。一方、クラス数が多い画像分類や物体検知(object detection)では同等レベルまで学習させることは困難でした。

労働環境など

フルリモートであるにも関わらず、スムーズに支障なくインターンを始めることができました。機械学習の研究開発に必要な設備が整っており、ミーティング等に参加していても風通しの良さを一貫して感じました。

一ヶ月強のあいだありがとうございました。

/assets/images/4781318/original/17d59443-2f48-4535-afdf-75bd8f7b54f4?1584514667)

/assets/images/4781318/original/17d59443-2f48-4535-afdf-75bd8f7b54f4?1584514667)

/assets/images/4781318/original/17d59443-2f48-4535-afdf-75bd8f7b54f4?1584514667)