はじめに

私たち Digeon は、神戸を拠点に AI 関連ソリューションやソフトウェア開発を行うスタートアップです。エンジニアが互いに学び合い、技術を磨く文化を大切にしており、定期的に勉強会を開催しています。

2025 年 8 月 2 日(土)、本社オフィスにて勉強会 「【神戸】苦しんで学ぶLLM」 を開催しました。LLM(大規模言語モデル)の理論や背景技術を腰を据えて学ぶことをテーマにした勉強会で、社内外から約15名が参加しました。

なぜ「苦しんで学ぶLLM」なのか

生成AIの急速な普及で「とりあえず触ってみる」機会は増えましたが、モデルの仕組みや理論を体系的に理解する場は意外と少ないものです。

そこで、LLMの理論についてしっかり腰を据えて学んでみようというコンセプトで、根本的な仕組みを数式や図解も交えながら丁寧にたどり直すことにしました。ブラックボックスに見えがちな部分を“手で追える”解像度まで落とし込み、実務へ応用する際の判断や検証が自分の頭でできるようになる——そんな学習体験を狙っています。

勉強会レポート

今回の勉強会は2 名の登壇者が発表を行いました。

大規模言語モデルを支える頭脳:Transformerを30分でつかむ

最初の登壇者は r‑hagihara‑max さん。

さまざまな生成系 AI の発展を支える基盤技術である Transformer の基本原理について、初学者にもわかりやすい解説が展開されました。

Self-Attention の直感的な意味づけ、マルチヘッド化の狙いなどを要点に絞って整理。既存の RNN 系との違いにも触れつつ、「なぜいま Transformer なのか」を短時間で学べるセッションとなりました。

登壇資料:大規模言語モデルを支える頭脳:Transformerを30分でつかむ

RAG × 評価で掴む!応答精度向上レシピ

続いて kazuyakinomoto さんの登壇。

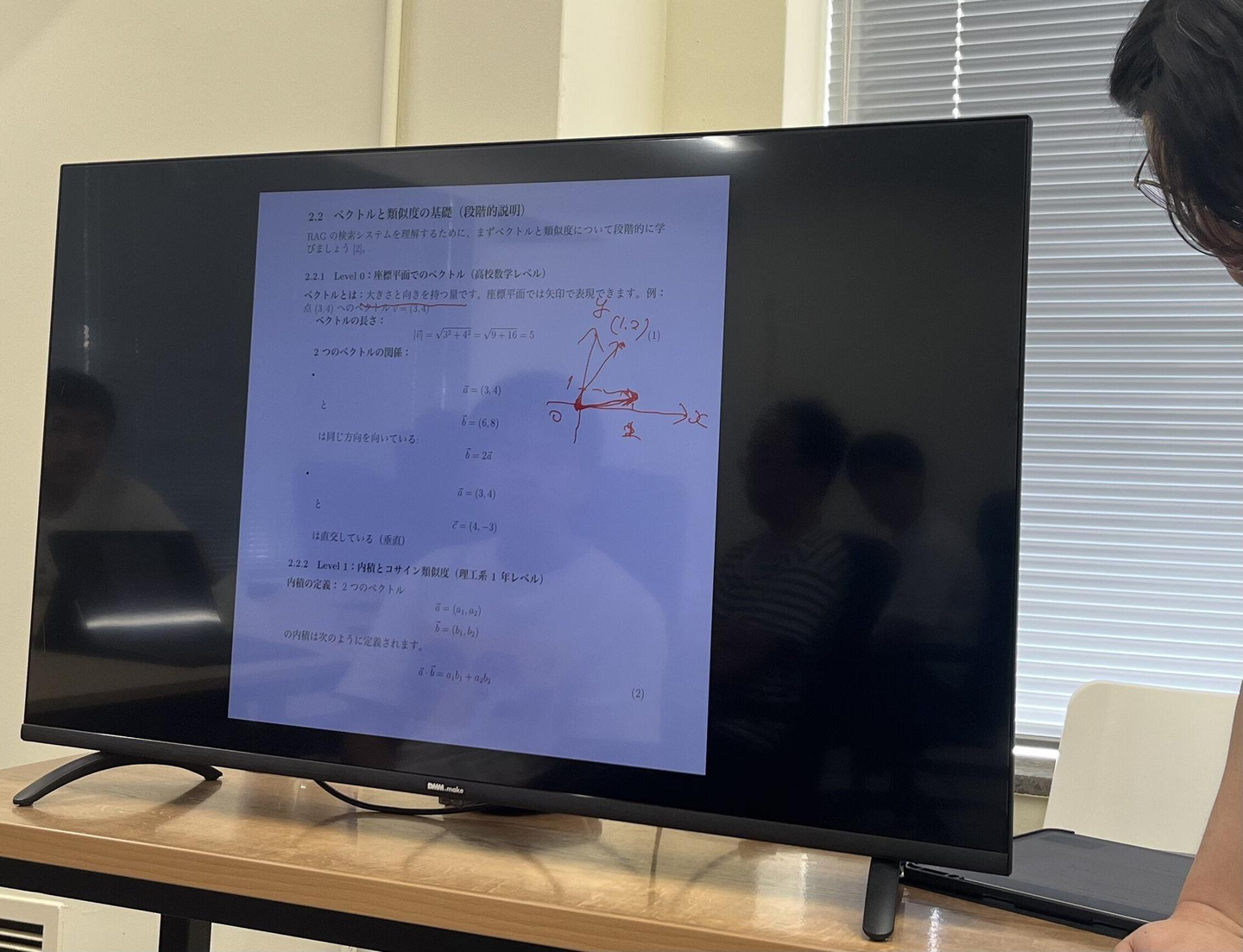

RAG(Retrieval-Augmented Generation)システムの理論から評価までを、数式や評価指標を用いながらわかりやすく、かつ深く学べる内容でした。

RAGシステムにおける検索手法のベクトル・行列を用いた解説(ベクトル埋め込みの概念、Attentionの手計算)を行った上で、評価観点(検索性能の伝統的な評価指標である再現率・適合率、RAG特有の指標である忠実性など)を体系的に整理し、LLM-as-a-Judgeによる改善サイクルの回し方まで具体的に紹介していただきました。

実際に画面に書き込みながら説明している様子

発表終了後はフリータイム。

参加者同士でスライドを見返しながら理解を深めたり、最近のAI活用について意見交換をしたりと盛り上がりました。

今後の展望

本勉強会では、Transformer の基礎から RAG×評価指標までを理論とディスカッションを通じてじっくり学び、モデルの仕組みを体系的に理解する有意義な時間となりました。今後も「苦しんで学ぶLLM」シリーズを定期的に継続し、基礎から応用までを丁寧に掘り下げる場を社内外のエンジニアとともに提供していく予定です。

次回もまた皆さまと深い学びを共有できることを楽しみにしています。

Digeon の勉強会について

- 開催頻度:月 1 回程度

- 対象:生成 AI、Web 開発、データサイエンスなどに興味のあるエンジニア(社外参加歓迎)

- 申込方法:connpass のグループページより随時受付

- 形式:LT/ハンズオン/もくもく会などテーマに応じて柔軟に実施

勉強会から生まれたナレッジは、エンジニアリングブログなどで社外にも還元しています。興味のある方はぜひ Digeon の connpass グループ、HPをチェックしてみてください!

社外の参加者・登壇者も募集中!

「LLM 初心者だけど話してみたい」「業務への適用事例を共有したい」——そんな方を Digeon は大歓迎します。テーマの深さより「学び合う姿勢」を重視しているので、遠慮なくご連絡ください。次回以降の開催情報は Slack チャンネルや X(旧 Twitter)でも告知予定です。

/assets/images/17497289/original/55dcfb99-69b0-41a4-8581-b126ee359ff6?1712115285)

/assets/images/17497289/original/55dcfb99-69b0-41a4-8581-b126ee359ff6?1712115285)

/assets/images/17497289/original/55dcfb99-69b0-41a4-8581-b126ee359ff6?1712115285)