今日は「なぜハルシネーションはなくならないのか?」というテーマについて面白い議論を見かけたのでシェアします。

先日、IBMのMixture of ExpertというYouTubeチャンネルで、OpenAIが発表した論文を取り上げていました。

内容を一言で言うと——ハルシネーションは技術的なバグではなく、言語モデルの設計上避けられない性質だ、ということです。

なぜそうなるのか?

従来の言語モデルは「次の単語を予測する」仕組みでした。最近はRLHF(人間のフィードバックを用いた強化学習)が導入され、モデルは「質問に対してもっともらしい回答を返すほど高得点」という形で学習します。

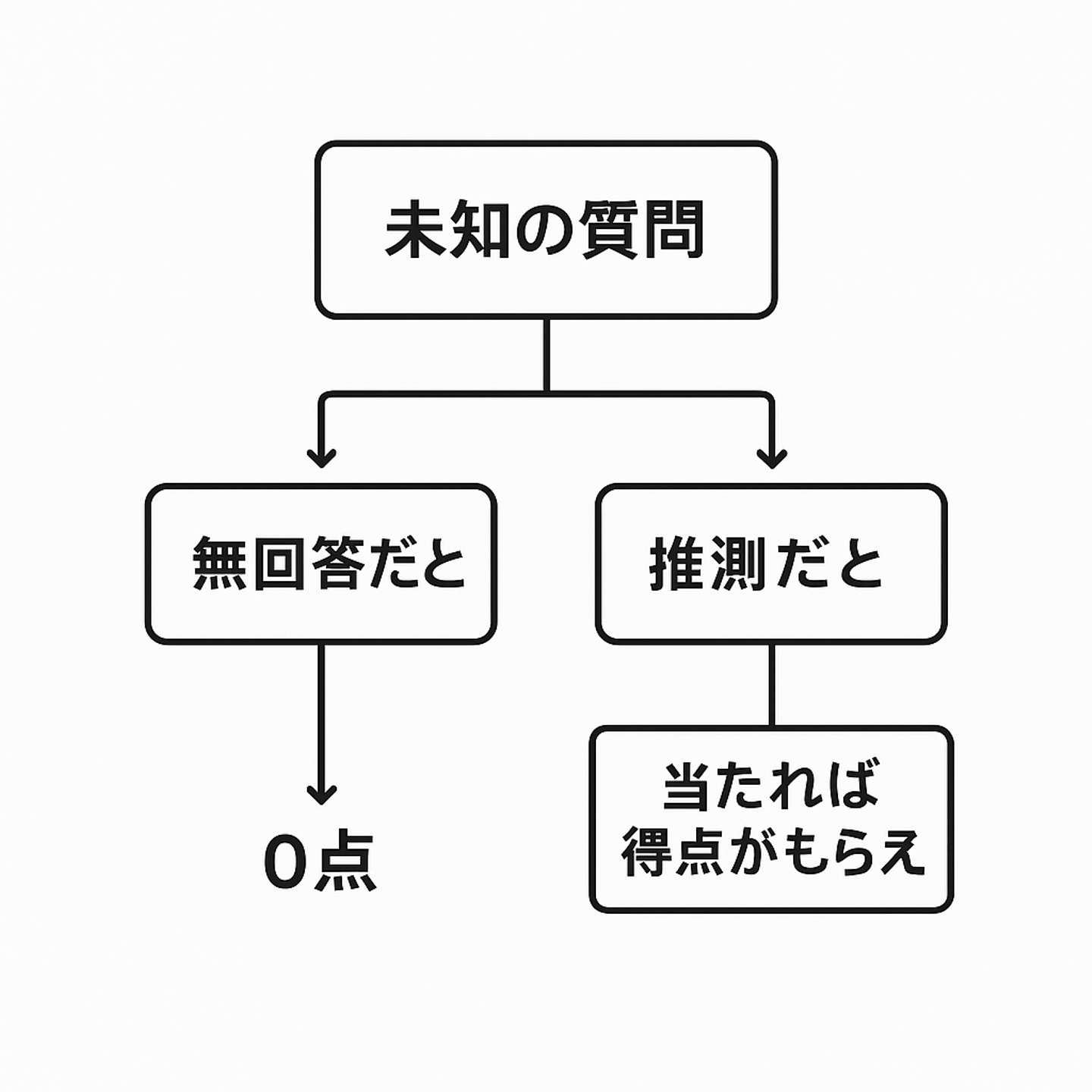

ここで面白いのは「分からないから答えない」だと確実に0点。

でも「分からないけどそれっぽいことを書く」と、当たれば点がもらえる。結果としてモデルは「分からなくても答える」方向に進化してしまうという点です。

これは昔の画像認識とかもっと小型のディープラーニングでも似たようなことがああって、犬か猫かを学習させると、トカゲやリンゴを見せられても「犬です」「猫です」と言い張ってしまう。AIに「分からない」と言わせるのは本当に難しい問題なんですよね。

ハルシネーションは本当に悪か?

ところで、議論の中で印象的だったのは、「もしハルシネーションが一切なかったら?」という問いです。

たとえば「海賊のフリをして答えて」と言ったとき、モデルが「私は言語モデルなので海賊ではありません」と返してきたら、面白くもなんともない。

僕はハルシネーション好きだなーみたいなことを言っていました。

つまり、ハルシネーションは「クリエイティビティ」と紙一重であり、完全に排除してしまうとAIがつまらなくなるリスクもあるということですね。

もっとも議論の中では海賊の話やクリエイティビティの話とハルシネーションの話は別物ではという意見も出ていましたが…

スタートアップ視点での気づき

私が面白いと思ったのは、「人間にとって価値がある挙動は何か」をゼロベースで考える必要がある、という点です。

- 事実を正確に返すべき場面

- 自信がなければ「分かりません」と言うべき場面

- あえて創造的に答えることが価値になる場面

こうしたシナリオごとに報酬関数を設計し直さない限り、ハルシネーション問題は本質的に解決しないのだと思います。

SaaSスタートアップをやっている立場として、AIが「どう振る舞うと人にとって価値があるのか」という問いは避けて通れないテーマだと改めて感じました。

ところで、ハルシネーションとも僕の仕事ともあんまり関係のない話ですが、最近ゲームのリメイクが多いですね。もう何十年もゲームをやっていないのですが、ドラクエ1、2、3のリメイクがでる(3はもう出ている?)とのことで、思わず紹介動画を懐かしくみてしまいました。

これってAIを活用することでリメイクを作る制作費が下がっているからガンガンだしている、なんて背景もあるんですかね…

https://www.youtube.com/watch?v=SjoxdH9qOTE

/assets/images/21301540/original/0092ac9f-f6ca-413c-a249-d928bf17a9b9?1749701307)

/assets/images/4253484/original/bc157435-6796-4d99-8745-f0e0679ce08f?1573106296)

/assets/images/4253484/original/bc157435-6796-4d99-8745-f0e0679ce08f?1573106296)