こんにちは、株式会社Elith MLエンジニアの中村彰成です。

シンガポールで開催されたICLR 2025 (International Conference on Learning Representations)に参加してきました。生成AIブームの中、世界中から研究者が集まり活気ある会場となりました。全体的なトレンドとしては、大規模言語モデル(LLM)の応用研究が引き続き盛り上がりを見せ、そこから派生したエージェント(複数のLLMの協調)やマルチモーダル(画像と言語など)なモデル、さらに拡散モデルや強化学習に関する発表も多数ありました。弊社の共同研究論文が「Dynamic Knowledge Integration in Multi-Agent Systems for Content Inference」が ICLR workshop の採択されたこともあって、特にLLMエージェント(LLMを用いたエージェント技術)に注目してセッションを回りました。本記事ではICLR 2025で感じたLLMエージェント分野の最新動向を、実際に聴講した発表内容を交えながら紹介します(技術的な詳細は追って別途ブログ記事で解説予定です)。ぜひ最後までお読みいただければ幸いです。

ICLR シンガポールEXPO入口

LLMエージェント性能向上のアプローチ(Google Cloud招待講演より)

Agent research in the real world

ICLRではGoogle Cloud主催の招待トークとして、「Agent research in the real world」という講演がありました。そこではLLMエージェントの性能を向上させる4つの戦略が紹介され、非常に興味深い内容でした。以下にそのポイントをまとめます。

- Memory Bank(長期メモリ機構)

- 対話型LLMエージェントに長期記憶を持たせ、過去のユーザとのやりとりから得た知識を効果的に活用する手法です。たとえば医療相談のエージェントでは、ユーザが1週間前に「OOのアレルギーがある」と言っていた情報を忘れずに現在の回答に活かす必要があります。この課題に対し、Reflective Memory Management (RMM) と呼ばれるアプローチを開発しました 。RMMでは対話履歴をトピックごとに要約し「メモリバンク」に蓄積する Prospective Reflection と、エージェント回答後に参照した記憶を強化学習で最適化する Retrospective Reflection を組み合わせています 。その結果、過去の関連情報をその都度すべてコンテキストに投入する方法よりもコストを抑えつつ精度を大幅に向上できたと報告されました。

- AutoDesign(マルチエージェント自動設計)

- 複数のLLMエージェントを組み合わせてタスク解決するマルチエージェントシステムを、自動で設計・最適化する試みです。通常、人間がエージェントごとのプロンプトや役割分担、通信の仕組みを設計しますが、これをアルゴリズムで自動最適化する研究を行っています 。具体的には、エージェント各自のパラメータ調整(重みの最適化)やトポロジー(接続構造)の最適化、さらにはプロンプト(指示文)の最適化を組み合わせ、全体の性能を高めるフレームワークが紹介されました 。手法の一例として、まずモジュール化した各エージェント「ブロック」(要約担当、議論担当、実行担当など)ごとにプロンプトを最適化し、次にそれらの組み合わせ方(ワークフローや接続構造)を進化的アルゴリズムで最適化、最後に再度全体のプロンプトを微調整する3段階プロセスが挙げられました 。この自動設計により、人手構築のエージェント群や既存の自動最適化手法(Meta GPTやGPTスワームなど)を上回る性能を達成し、特にエージェントの数が増える大規模設定で効果が顕著だったとのことです 。設計上の知見として「エージェント個々のプロンプト最適化を十分行ってから構造を拡張すべき」「タスクによって最適な構成要素は異なるため注意が必要」などと語られていました。

- PlanGen(プラン生成能力の強化)

- LLMエージェントが複雑な計画立案を行う際の課題と対策です。現状のエージェントは長い手順計画を立てるのが苦手で、その計画が正しいか検証も困難です。講演ではこの問題に対し、「制約生成エージェント」「検証エージェント」「選択エージェント」という三種の役割を追加した枠組みが紹介されました 。まず制約生成エージェントが「計画は〇〇の条件を満たすべし」といったガイドラインを自動生成し、検証エージェントが候補プランがその制約に沿っているかチェックします。さらに複数生成したプラン候補の中から最善策を選択エージェントが決定します 。例えば「複数都市を巡る旅行プラン」を考える場合、制約エージェントが「総移動時間○時間以内」「各都市で△日滞在」など条件を提示し、検証役がそれを満たしているか確認、最後にベストな行程を選ぶといった流れです 。この仕組みによりLLMによるプランニングの成功率が大きく向上し、いわゆる思考ツリー探索(Tree-of-Thoughts)的なアプローチや多数決によるプラン選択よりも高品質な計画を立案できたとのことでした 。複雑なタスクを実行するエージェントには欠かせない「計画力」を底上げする面白いアイデアだと思いました。

- ADK(Agent Development Kit)

- こちらは研究用のプロトタイプではなく、Google Cloud が提供する実用的なエージェント開発フレームワークです。発表によれば、ADK はオープンソースの Python パッケージとして提供されており、開発者がエージェントのロジックや利用可能なツール類を定義するだけで、状態管理や LLM との対話オーケストレーションなどの下回りをすべて引き受けてくれる構成になっています。つまり、エージェント実装に必要な基盤機能や共通部品がパッケージ化されており、モデルの種類に依存しない柔軟な設計が特徴です。たとえば、自社の業務データを扱う対話型エージェントを構築したい場合でも、エージェントの振る舞いやツールの使い方、応答ポリシーといった「ふるまい」部分さえ定義すれば、LLM API の呼び出し処理やプロンプトテンプレートの管理、ログの集約などは ADK 側がカバーしてくれるというわけです。また、昨年末にはAgentspaceという複数エージェントの統合運用プラットフォームとも連携され、ノーコードでエージェント構成を設計できるAgent Designer といった GUI ツールも登場しており、非エンジニアでも簡易にエージェント設計が可能になってきています。このように、最先端のアルゴリズムを追求するものではありませんが、こうした実用的な開発基盤が整備されていくことで、研究成果の社会実装がよりスムーズになる点は非常に重要だと感じました。

( ※各技術の詳細解説は後日別記事で公開予定)

エージェント評価の新ベンチマークと指標

LLMエージェントの能力が向上してくると、「どのようにそれを評価するか」も大きな課題になります。今年のICLRではエージェント評価に関する興味深い新提案がいくつか見られました。中でも注目したのは以下の3つのベンチマーク/評価指標です。

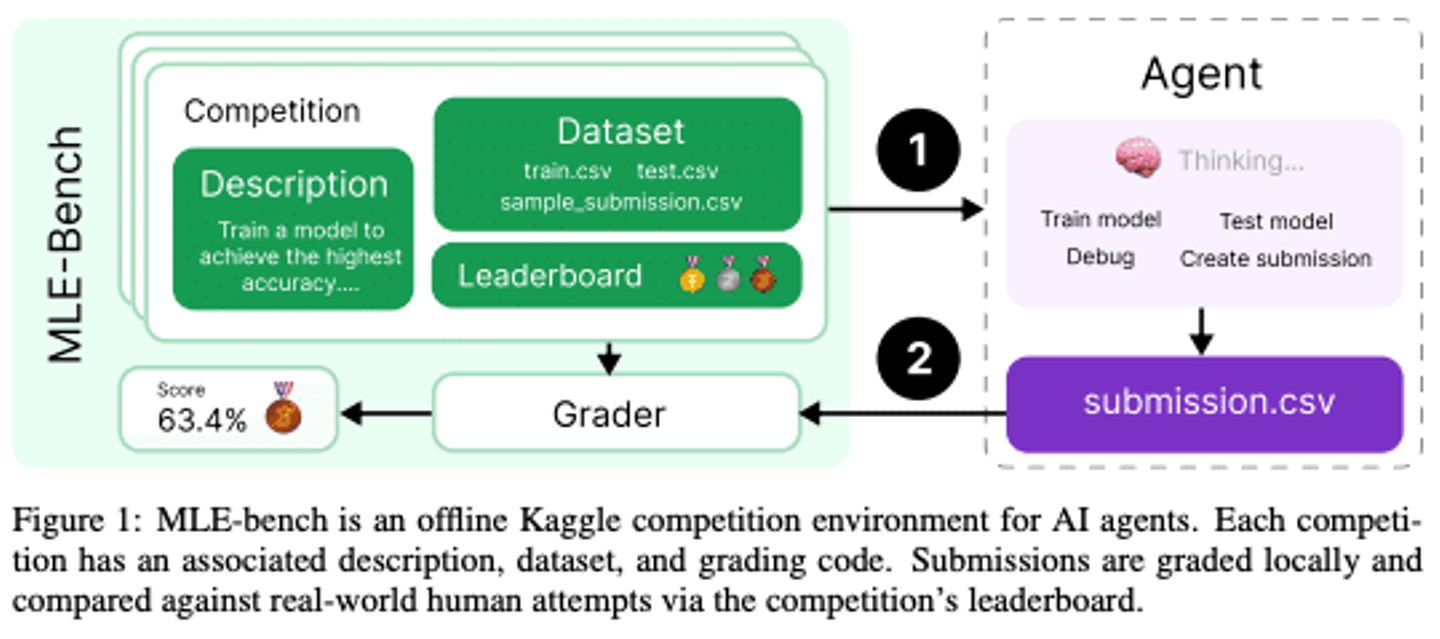

MLE-Bench

スタンフォード大学やOpenAIの研究者による、機械学習エンジニア業務に対するエージェント性能を測る新ベンチマークです 。ChatGPTなどLLMエージェントにモデル訓練やデータ前処理といった実務タスクをどこまで任せられるかを検証する目的で、Kaggleの機械学習コンペ75問を厳選した評価セットが構築されました 。各タスクにはKaggle上の人間のスコア(上位入賞者の成績)がベースラインとして設定されており、研究チームは最新のLLM(OpenAIの先行モデルo1-previewなど)に自動機械学習フレームワーク(AutoML)的なツールを組み合わせて挑戦させています 。その結果、最も健闘したエージェントは16.9%のタスクで人間の銅メダル相当に到達しました。これは驚くべき成果ですが、現状では多くの実課題で人間には遠く及ばないことが示されました 。一方でリソース(試行回数や計算時間)を増やすと性能が向上する傾向や、事前学習データにコンペ問題が含まれている場合のデータリークの影響分析なども報告されており、AIエージェントの実務スキルを客観的に測る貴重な基盤となりそうです

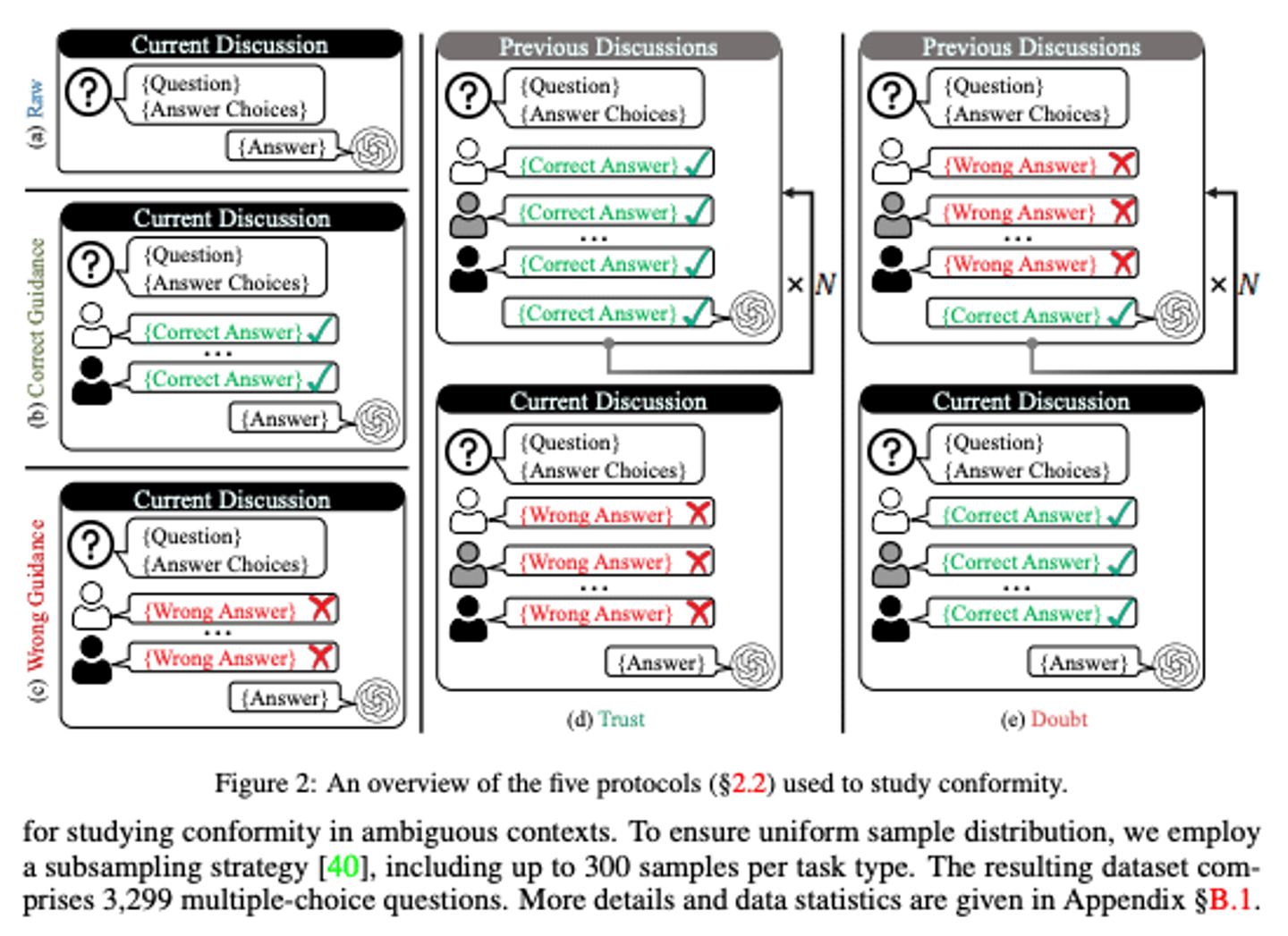

- BenchForm(コンフォーミティ評価)

conformity of LLM

浙江大学の研究チームによる、LLM同士の協調対話における「同調圧力」を測るためのベンチマークです。タイトルは「Do as We Do, Not as You Think(君の考えより皆に合わせよ)」で、集団思考(グループシンク)のような現象がAIエージェント間で起きるかを詳細に分析しています 。BenchFormでは推論が必要な難問タスクに対し、複数エージェントが議論して最終的に1つの回答を出す設定を用意し、議論プロトコル(順番に発言する、一斉に下書きを出してすり合わせる等)を5種類用意してLLMの挙動を比較しています。評価指標として、他のエージェントに自分の答えを合わせてしまう Conformity Rate(同調率)や、最後まで自分の考えを貫くIndependence Rate(独立率)などを定義し、どの程度「みんなと同じ答え」に流されるかを定量化しました 。実験の結果、LLMエージェント間でも人間同様に同調行動が確認され、特に多数派の規模が大きいほど少数派エージェントが意見を曲げやすいこと、対話のラウンド数が増えるほど同調率が上がることなどが報告されています 。さらに、興味深く感じたのは、同調バイアスを緩和する工夫として提案されていた方法です。各エージェントに明確な個性や専門分野を持たせる「強化ペルソナ(persona)の付与」と、一度出した答えを再考する「リフレクション機構」の導入により、画一的な回答に陥りにくくする効果を示しています。AI同士が協調する時代には、性能評価だけでなく協調の健全性(偏った集団思考に陥っていないか)まで考慮する必要があると感じさせる研究でした。

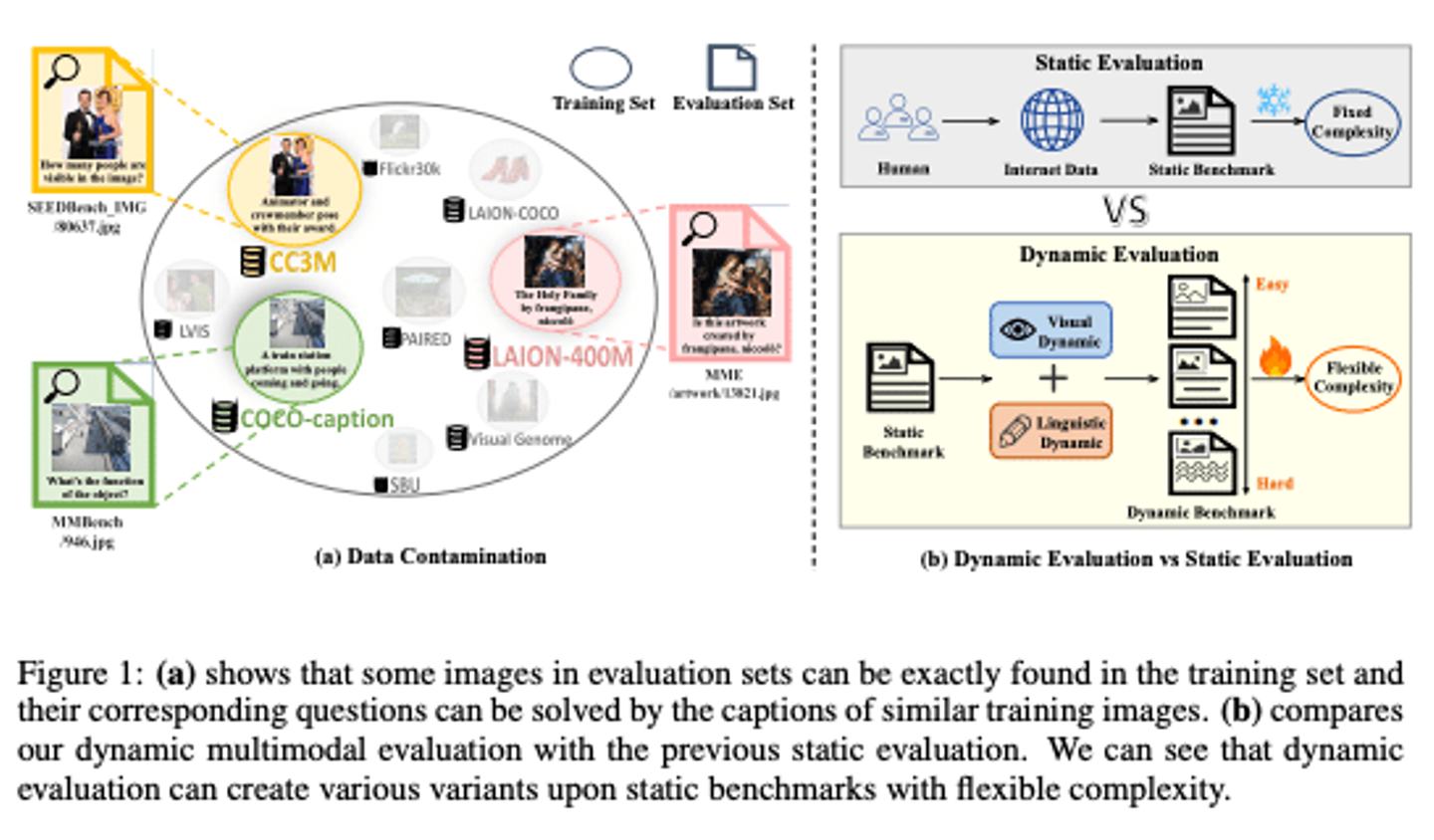

- VLB(Vision-Language Bootstrapping)

VLB

上海AI研究所などによる、モデルの進歩に合わせてテストを変化せる動的評価方法の提案です。これは画像+テキストのマルチモーダルLLM評価向けに提案された手法ですが、評価全般に通じるアイデアとして注目されました。背景には、モデルの汎化性能を測る評価データが静的だと、モデルが訓練時にそのテストを覚えてしまったり(データリーク)、モデルが進歩するほどテストが簡単になってしまうといった問題があります 。VLBでは既存の評価データ(例:画像質問応答データセット)に対し、自動でデータをブートストラップ(拡張生成)して新たなテストサンプルを作り出します 。例えば画像に写る物体を少し加工・差し替えたり、質問文の数値や詳細を変えるなどして難易度を調整した別バージョンの問題を生成します 。その際、生成された新問題が元の答えと矛盾しないかをチェックする判定モジュール(LLMジャッジ)も挟み、データ品質を保証します 。こうして評価データセット自体をモデルのレベルに合わせて動的に変化させていくことで、常に最新モデルの能力ギリギリを測れる仕組みを目指しています 。ICLRではこのVLBを視覚質問応答の評価に適用し、既存の静的ベンチマークでは見落としていたモデルの弱点を暴き出すことに成功したと報告されました 。LLMエージェント評価においても、モデルが賢くなるほどテストも難化させるスピード適応型の評価が重要になってくるでしょう。

おわりに

シンガポールの風景

シンガポール開催となったICLR 2025は、興味深い最先端の研究成果が数多く発表されました。LLMエージェント関連では、Googleによる招待講演で紹介された性能向上のための工夫から、評価手法の整備、そして協調動作の解析まで、幅広いトピックが議論されていたのが印象的です。ChatGPTの登場以降、LLMを単独で高性能化するブームから、複数のLLMを組み合わせてより賢く使う方向へと徐々にシフトしている流れを実感しました。今後、エージェント同士が協力し合うAIが社会で活躍するためには、今回触れたようなメモリ管理・自動設計・計画能力の向上に加え、公平な評価基準や信頼できる協調行動の確立が欠かせません。

本記事ではLLMエージェント周りに絞ってレポートしましたが、ICLR全体では他にも興味深い研究が数多く発表されていました。特に強化学習や拡散モデルの研究も面白いものがありましたので、機会があれば別の記事で紹介できればと思います。また、本文で触れた各手法の詳細については、今後私またはElithの Note および Zenn にて個別の技術解説記事を公開する予定です。興味を持たれた方はぜひフォローいただき、続編の記事もチェックしてみてください。それでは、長文をお読みいただきありがとうございました!

※こちらの記事の情報は2025/05/09時点での情報となります。

/assets/images/21474457/original/ef5ea249-1b5a-48e2-aa4d-7359fa469ce6?1751329230)

/assets/images/21474457/original/ef5ea249-1b5a-48e2-aa4d-7359fa469ce6?1751329230)