株式会社 Elith CAIO の下垣内です。弊社の共著論文「Dynamic Knowledge Integration in Multi-Agent Systems for Content Inference」が ICLR workshop に採択されたため、研究メンバーで ICLR 2025 (4/24-4/28) に参加しました。

ICLR は International Conference on Learning Representations の頭文字です。AI に関するトップカンファレンスで、今年は11672本の論文が投稿され、3704本が採択されました。このカンファレンスには Learning Representation というまとめ方のため、幅広い分野の研究が投稿されます。LLM や拡散モデルなどの生成モデル、エージェントを用いたそれらの応用はもちろん、ロボティクス、材料物理系のの応用、教育に関する研究なども見られました。

このレポートではまず、幅広い論文の整理も兼ねて投稿された論文やワークショップなどから技術トレンドを解説します。その後、会場の雰囲気や現地に行って感じたことを紹介し、付録としてシンガポール観光等について少し触れます。

技術トレンド

レベル感

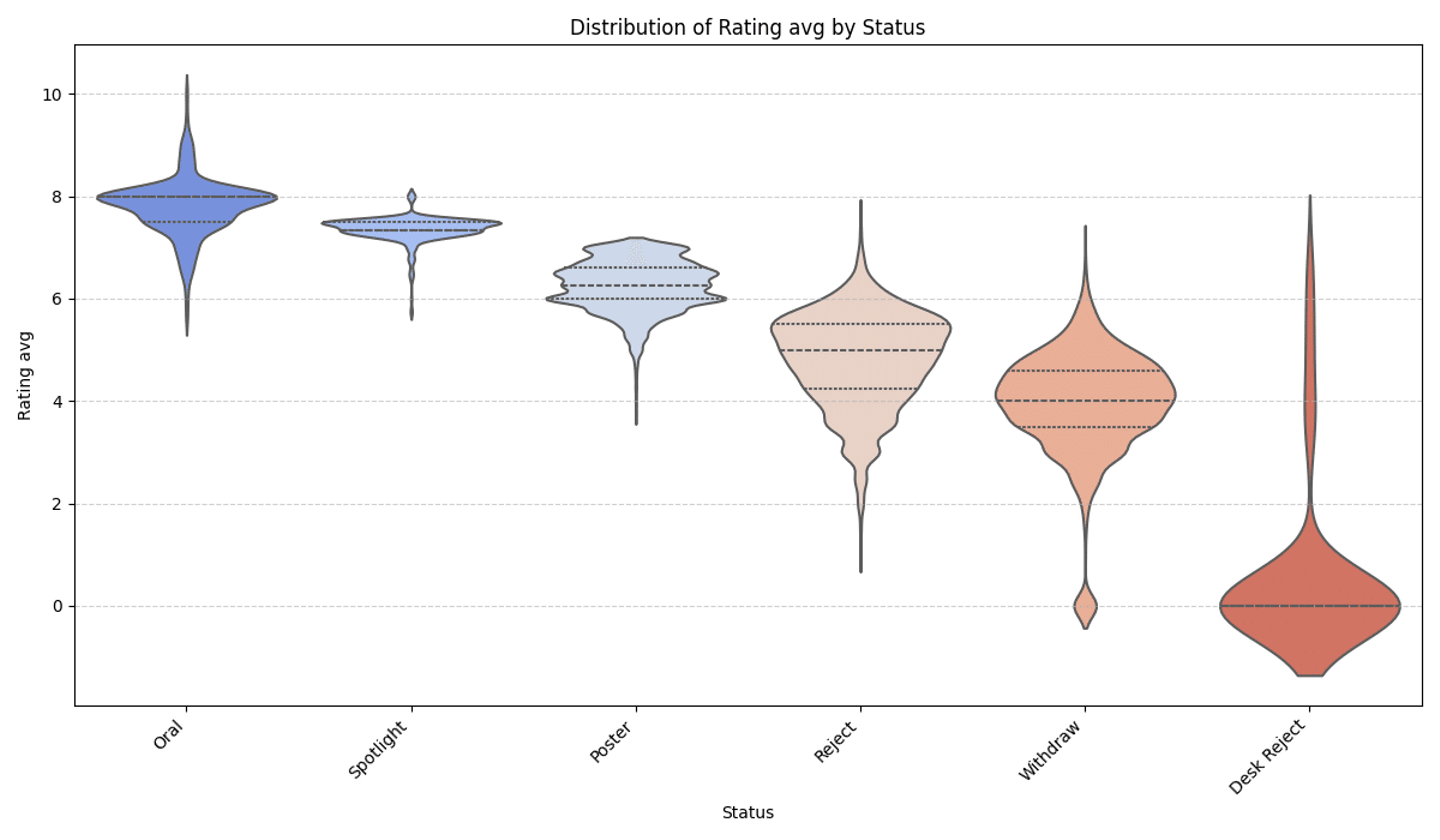

今回の ICLR の採択ステータスとレビュワーの平均評価 (10点満点) の関係を表すバイオリンプロットを以下に示します。

採択ステータスとレビュワーの平均評価関係

採択されるにはおおよそ 6 点は必要だったようです。また、 spotlight には 7 点、 oral 発表には 8 点程度必要でした (本会議と workshop でも大きく異なるので一律ではないですが)。

全体傾向

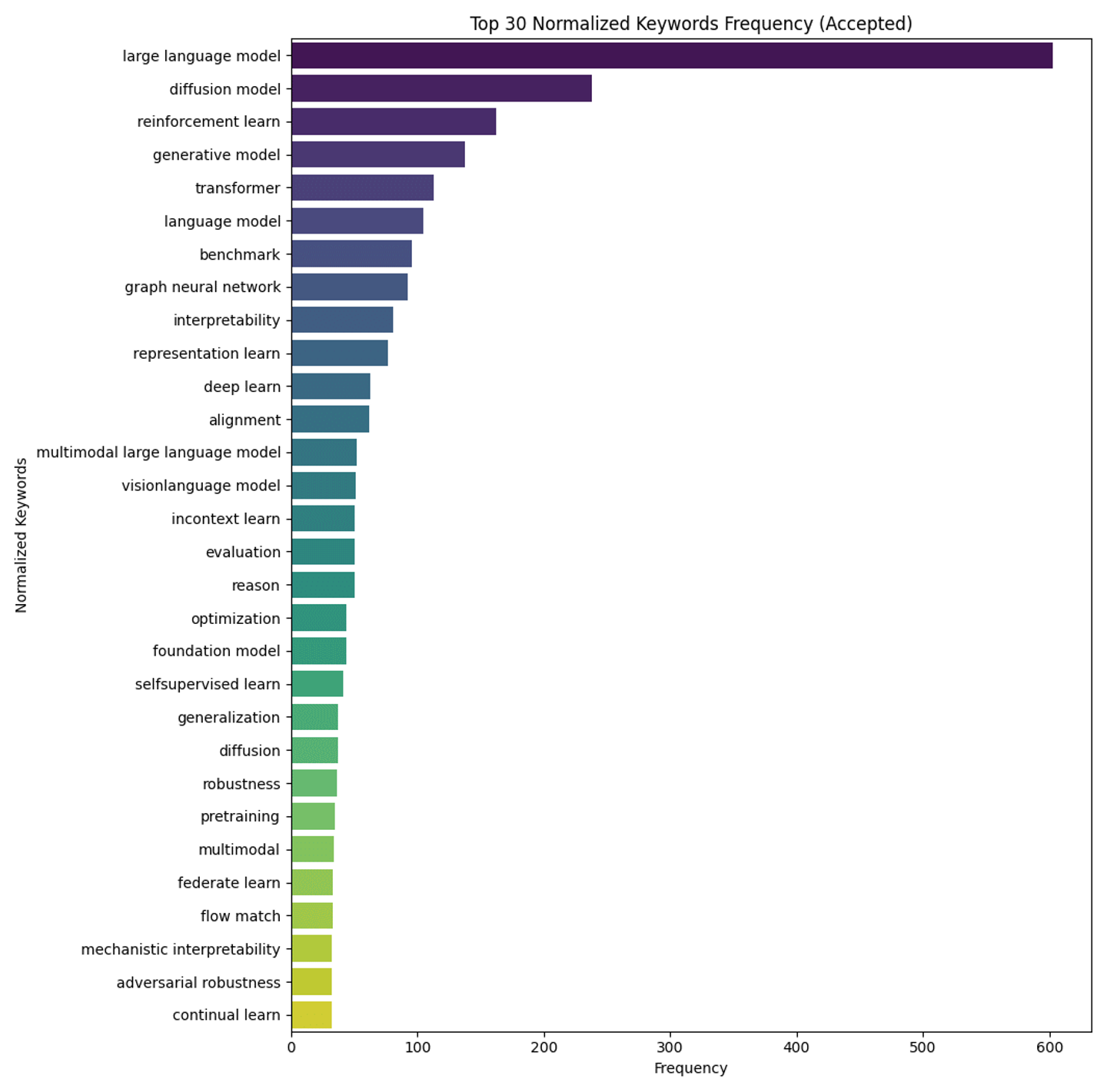

全体の傾向を掴むためにまずはキーワードの分布を見てみましょう (normalize しているので reinforcement learning などが reinforcement learn と表示されています)。

キーワード分布

大規模言語モデルがダントツで多く、次に拡散モデル、強化学習ときています。Graph Neural Network に関する研究も100件近くあったようです。また、ベンチマークに関する研究も多かったです。実際、 LLM やエージェントに関する評価指標を提案する研究のポスターを会場でもよく見かけました。

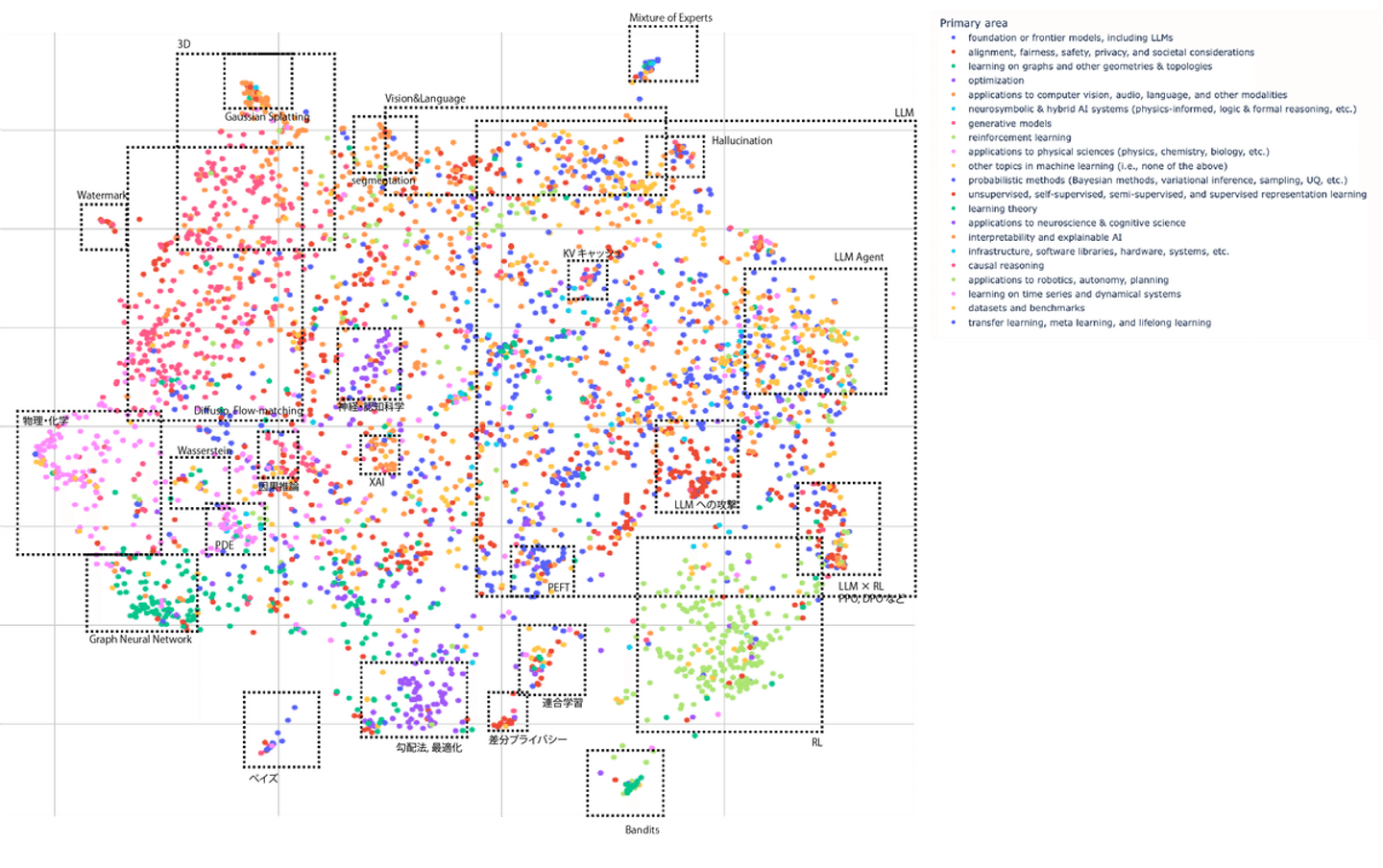

下図はAbstract ベースで意味をベクトル化して表示したものです*。

*multilingual-e5-base, UMAP を利用

全体的な傾向としてはヒストグラムの通りです。LLM の中には、KV キャッシュや、PEFT (Parameter Efficient Fine-Tuning) などに関する研究が含まれていました。

ワークショップ

ワークショップは40個開かれました。一覧は以下のページから確認してください。

https://iclr.cc/virtual/2025/events/workshop

大まかには以下のようなトピックに関するワークショップが開かれています。

- 基盤モデル, LLM

- 効率化・最適化

- 信頼性・安全性・アラインメント

- データ

- 科学のための AI

- ロボティクス・エンボディメント

- 金融・教育など専門ドメイン

弊社が投稿したのは科学のための AIに関する workshop 「Towards Agentic AI for Science」です。

個人的に興味深かった研究

ここでは、個人的に面白かった研究を簡単に紹介します。それぞれについての詳細を後日、Elith のテックブログにまとめようと思っています。

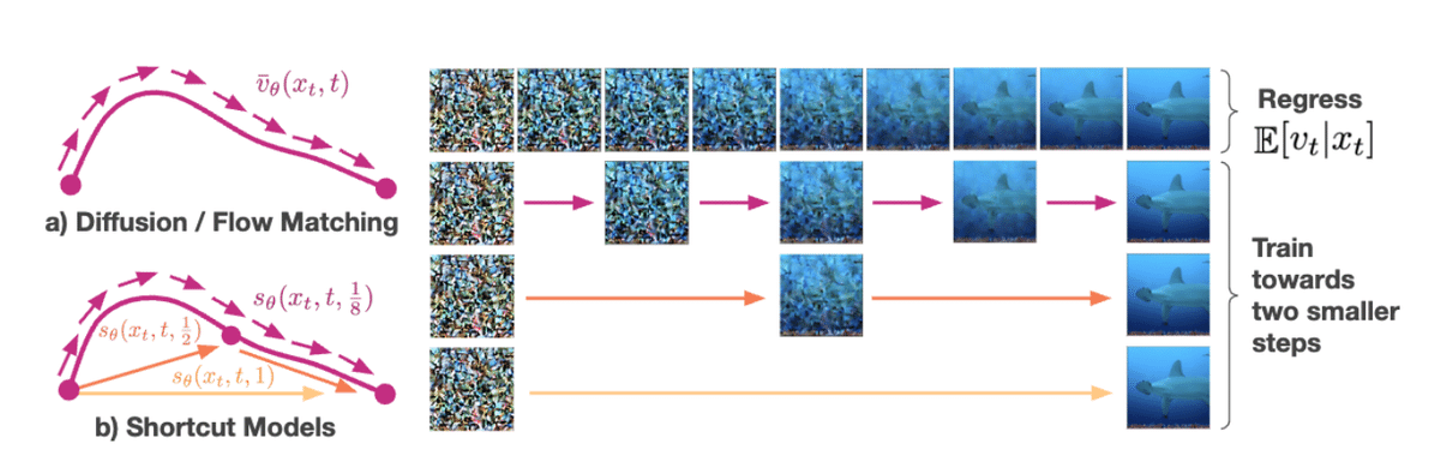

One Step Diffusion via Shortcut Models

paper link:

上記論文内の画像引用

拡散モデルやフローマッチングでは、高品質な画像が生成できる一方、生成時に多くのステップが必要で高コストになります。これまでに提案されてきた少ないステップで生成するための手法では、モデルを蒸留するなどに段階の学習が必要であるなどの問題がありました。

この研究で提案した Shortcut Model ではステップ幅を条件に入れた生成を行うことで、一度の学習でさまざまなステップ数での生成に対応でき、少ないステップ数でも高品質に生成できるモデルの学習に成功しています。

会場QA

Q: Rectified Flows の Reflow Pairing との違いは、事前学習済みモデルに適用するのではなく、学習時に self-consistency loss を利用することでしょうか

A: そうです。Shortcut Model では End-to-End で学習でき、 reflow のようなニ段階のプロセスが必要ないです。

↓Oral の会場はかなり人が多くて立ち見でも入れない人がいるくらいでした

会場の様子

Block Diffusion: Interpolating Between Autoregressive and Diffusion Language Models

paper link:

Block Diffusion Language Models は1トークンずつ推論する自己回帰モデルと、全体を一気に生成する拡散モデルを橋渡しするような研究です。前者だと推論効率が悪く、後者だと品質が下がったり固定長になるといった問題がありました。このモデルでは、ブロック単位には自己回帰的に、ブロック内では拡散モデルで生成することで両方の欠点を克服します。

この研究では単に上記のアイディアを実装しただけでなく、上手く学習するための工夫や効率的な学習にかなり力を入れているところが良かったです。

会場QA

Q: ブロックサイズ1は試したか

A: Yes. 自己回帰的な目的関数を正確に再現することを確認した。

Q: 蒸留など、他の研究での高速化手法とブロック拡散を組み合わせることはできるか

A: Yes. 各ブロックの拡散について、蒸留を含む他のアプローチを継承できる。

↓ 発表は One Step Diffusion の直後でした。少し人が入れ替わったので中の方で聞けました↓

会場の様子

その他感想

私は修士に入った時ちょうどコロナで学会がオンライン開催だったので、国際会議に現地参加するのは初めてでした。会場には予想以上に大量の人が集まっており、PC 上で数字で見るのとは迫力が違うなと思いました。また、この人たちが全員 AI に学術的な関心があるのかと思うと非日常感が強かったです。

大学院の同級生・後輩や、高専時代の同級生も ICLR に採択されており、会場で会えたのでエモでした。高専の同級生の論文は離散集合に対するBregman ダイバージェンスに関する研究で、NN で学習可能な形にして実験まで行っており非常に面白かったです↓

今回、4/24から4/28までの5日間で様々なインスピレーション得られて、研究したい欲が非常に強まりました。メモ帳にはたくさんの研究アイディアが溜まっています。業務もしっかりこなす必要がありますが、Elith としても研究力というのは1つの強みだと思うので、こちらにも力をいれていきたいです。

会場の写真など

オープニングセレモニーは獅子舞でした↓

オープニングセレモニーの様子

ロボティクス系の発表に行ったら実物が置いてありました↓

ロボティクス系の実物

※こちらの記事の情報は2025/05/07時点での情報となります。

/assets/images/21474457/original/ef5ea249-1b5a-48e2-aa4d-7359fa469ce6?1751329230)

/assets/images/21474457/original/ef5ea249-1b5a-48e2-aa4d-7359fa469ce6?1751329230)